关于写作

现在几乎一周可以出一篇文章,闲暇里我也想过这个问题,也获得了一些结论。

关于写作时间 :对我来说,写作已经不需要消耗多少时间了,因为我在电脑前坐下写作之前,文章的内容和大体框架实际上已经完成了,这只是一个再现的过程,或者把之前整理的思路重现的过程。是的,写作其实是走在路上完成的。

关于写作目的 :现在写作的目的已经完全不是我预想的目的了。最开始的想法是可以帮助他人,但是写作这件事已经摆脱了我的设想,朝着自定的方向发展了。他想做什么呢?

以前跟小郭出去逛街,不像真实意义上的逛街,不重在吃和买,倒像是一次长谈。我们一边走一边讨论生活,交换价值观,很多思想也都互通有无。我喜欢这种交流。

而现在的写作,更像是跟自己进行的一次长谈。平时很少有机会可以静下来跟自己聊聊,现在有了一段跟自己交换思想的时间。当然也是跟看到这篇文章的人交流,当然,交流的目的还是互通有无,不问对错,只需要了解。从这一点上来说,写作是自私的。

其次呢,写作更是一种学习的途径。我看很多人的技术博客或者文章,都是对过去的一些事情的总结。我现在写作并不是对过去的总结,或者在必要的时候总结过去只是为了更好地梳理以帮忙到现在或未来。每当我想学习一个新东西的时候,就会在日程上安排一个写作计划,制定一个deadline,积累素材的过程实质上就是一个学习的过程。

关于第二点,划下重点, 写作不是总结 。

在写作的过程中,我还会有一些额外的收获,比如在写作这篇文章时,在希望有一个手机全局软件可以作为GTD收件箱的时候,我想到了闪念胶囊,但是由于苹果的封闭性,市场里只能找到一些拙劣的替代品。虽然锤子科技17年有说ios版在开发中,可以已经流产了。

一句话,如果想学习某个东西,就制定一个写作计划(思想)或者做一个成品的计划(技能)吧!

时间管理简史

混沌期

学生时代并不需要管理时间,时间都是被学习管理好的,明明白白。

到了大学的时候,也不太需要管理时间,想做什么做什么,想做的不多,时间倒挺多。

这段时间我称它为混沌期,或者叫被动管理期。一直延续到工作以后。

初见workflowy

工作以后,时间安排的重要性就慢慢体现出来了。

随着时间的推移,我们cover的事情越来越多,而精力又越来越少,不得不将自己的时间管理起来。

时间管理,其实是精力管理。

工作以后,我们或早或晚地会意识到计划的重要性。它可以指导我们时间或精力的分配,不至于因为事情太多感到茫然无助。而且在汇报工作时,也有一个好的参考。

最开始我是记在文本里的,一天一记,定时总结(大部分时候都感觉总结没必要,就直接跳过了。走到某天意识到遗失了一批最有价值的宝藏 :p)。

PS: 刚才突然意识到很多人为什么用:-p而不用:p,因为:)在编辑器里的括弧会匹配到左括弧我的天。

后来,认识了workflwy(好像是小金推荐的),瞬间被它的简洁和优雅打动。我甚至极度迷恋到以为可以用它来管理我的整个后半生。

最初使用的过程中,除了加载会有点慢,没有发现其它的问题。我至今都不明白,zf做的这些“努力”到底是为了什么。

不过在后来的一次更新中,登录后数据怎么都加载不出来。跟开发者反馈后,经过复杂的五步操作,解决了这个问题。后来这类问题又反复了几次,最终决定卸载。

在写这篇文章前又试了一下,还没有恢复,也可能是手机缓存的问题。不过我不想再把自己的精力浪费在别人反复出现的问题上了。这时候,我意识到纯文本管理的便捷性,这是我使用org-mode的一个重要原因。

我换用了中国人开发的workflowy copy版app幕布,数据加载没有问题。唯二的缺点是使用更复杂和夹杂着使用体验上的bug(键盘RETURN键失效)。第一点是团队的设计原则问题,没法改变。第二点已经反馈给官方。

不过,GTD才是解决时间管理的真正方法。

由于我写作大多是在闲暇时间完成的,所以习惯用手机构建,workflowy类软件多终端同步,可以解决这个问题。注意,workflowy适合整理思路,不应该被用来做时间管理。

apple notes

这是我在换到苹果全家桶后非常喜欢的一款软件,它简单,开箱即用,支持多终端。

我曾经有很长一段时间用它来记录信息,支持图片,搜索也方便。我还用它来写文章,写完后直接拷贝到blog就可以发布了(后来意识到用它写文章是不方便的,手机适合助攻,电脑才是王道)。

甚至我尝试过用它做todo,不过在做todo的过程中,发现了一堆bug,皆因它自动把todo条目转换成图形导致。这让我再一次意识到纯文本的重要性。其实转换不是问题,但是操作的一定要是文本,否则出了问题就是单向不可恢复的。

拥抱GTD,拥抱org-mode

如果你没用过GTD,我要说明一点的是,它不止是todolist。

这一点值得被反复强调,它不止是todolist。

一个很重要的关键词是收件箱,GTD是一个系统,它会把你接收到的思想或者事件,都放到收件箱里。收件箱会再次被转交到GTD系统,来缓解我们在记忆上的压力和精力分散的问题。

为什么要单独提收件箱,因为org-mode里的GTD已经很完整了,经过少量的配置就可以高度可用。剩下的问题只有,如何跟外部打通。最为关键的就是,用什么来做收件箱?

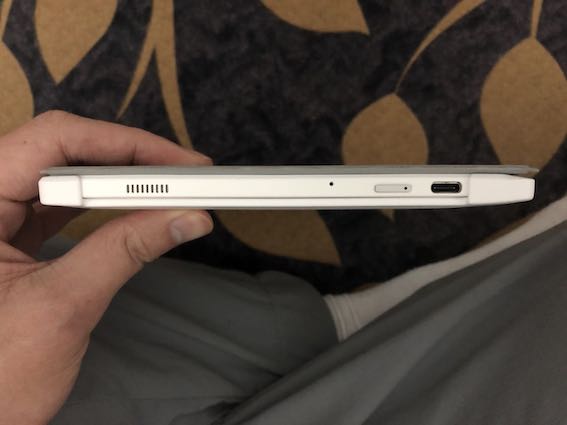

如果使用org-mode,电脑端已经毫无疑问是remember命令,但是手机端呢?当我们离开办公场所,离开家,只有一个手持设备时,如何快速记录临时的想法呢?

我现在仍然坚定的认为,闪念胶囊,或者说闪念胶囊之类的设计,是最理想的收件箱。

我尝试过使用notes来做收件箱,但是效果并不理想。打开notes需要很多的思考,它不是“不假思索”的。而且手机上的回车和电脑上的回车有天壤之别,电脑上的回车跟其它键是一致的,但手机上的回车跟字母键(在人的直观感觉上)是分离的,而且回错了要删除,删除键也是分离的。

退而求其次的方法是使用一个todo工具或者workflowy类工具。

任务类型的思考

就我个人的思考,任务分很多种,每种任务的处理方式是不一样的。

对任务类型的分类,是这篇文章中思考密集度最为集中的地方,也是这篇文章指导我要思考的点。

任务的分类并非严格按照重要紧急四象限排列,在GTD的实践中,我发现它们之间有些许不同。所以我决定先忘记四象限,按照GTD的思路整理一下。

临时性紧急任务

此类任务可能会打断我们当前的状态,需要立即去执行。

比如刚才我在写作的过程中,突然外卖到了,门铃响了。这就很紧急,如果我不给他开门,中午就没饭吃了。

临时性非紧急任务

此类任务也会打断我们的状态,但是由于不紧急,可以将它加到 收件箱 ,然后快带恢复到之前的状态。

它会耗费我们一定的精力,但是不多,包括两方面:一是任务细节的沟通,二是加到收件箱的操作。所以为什么我很重视收件箱的设计,因为它是保证我们可以快速恢复到正常状态(之前状态)的非常非常重要的一环。所以收件箱最好是全局的,是可以一键唤起的。

这类任务当我们整理收件箱的时候,会加入待办,或者更进一步,对待办排期。

一个很好的例子就是,你的朋友打电话约你周末去图书馆看书。

注意,上面这两类任务还不能称其为任务,或者还没有进程GTD系统。因为它们一个不必要进,一个还在收件箱里等待进。

后面的这几类任务,就都是GTD系统里的任务了。

scheduled任务

临时性非紧急任务可以转为排期任务,它很重要,但是不会立即去做。它不仅是重要不紧急,而且还有一个属性,就是利用一段确切的时间(比如3个番茄钟)是可以完成的。

deadline任务

这类任务比较有目标、有雄心、有毅力,它表示你要在一段时间内努力达成某种效果。

比如,你计划在半年内打到《王者荣耀》王者段位。这类任务需要很好的自控能力,因为达成任务需要消耗的时间不确定,如果你没有自信,可以把任务细分为子任务,这样就拆解成了排期任务,实现的难度就大大降低了。但是没准,你就是想挑战一下自己呢?

repeat任务

这类任务挺悠闲,没有任务,或者说完成它们本身就是任务。这类任务更侧重提醒功能,去做而不是做完。

比如,我做了一个repeat任务,为了保持自己的形象,每隔两天刮一次胡子。

maybe任务

这类任务还没有排期,不重要也不紧急,甚至不一定要做。它只是我们的一些奇形怪状的想法,可能在某天突然来了灵感或者突然变得重要,然后就被加到我们的排期里。也可能这辈子都不会被我们注意到了,谁知道呢?

但是一定要记下来,好让我们知道,我们已经考虑过了,而不是再考虑一次。

哪些任务需要记录耗时

我喜欢org-mode里的org-clock-in功能,它能让我知道做一件事耗费的时间。

当然,工具就是工具,不是所有的事情都需要知道耗时的。

比如,我每隔四天做一次俯卧撑,但是并不需要知道它的时间。根据我最开始的计算,每次都是3分钟左右。

阅读是一个与之相对的例子,因为我每次阅读是以章节为单位的,而不是时间,所以我需要记录每次阅读的时间,以知道读一本书需要多在成本。我不喜欢那种每天花 半小时 读书的计划,它太死板,书有逻辑性。

再比如写作,不同的文章内容,耗费的精力和时间是不一样的。当我在写下这篇文章时,编辑器的下方会提醒我在这篇文章上花费的时间。看,已经1小时40分钟了,不过这篇文章也已经接近尾声了。

最后一句话,适合自己的才是最好的。